如今的 AI 領(lǐng)域,大多數(shù)大語(yǔ)言模型在很大程度上仍以「黑箱」方式工作,即使是專業(yè)的研究者也難以完全理解它們的內(nèi)部計(jì)算過(guò)程。因此,提升模型的透明度有助于分析和解釋大語(yǔ)言模型產(chǎn)生幻覺(jué)、行為不穩(wěn)定或在關(guān)鍵場(chǎng)景做出不可靠判斷的潛在原因。

就在今天,OpenAI 發(fā)布了一項(xiàng)新研究,使用新方法來(lái)訓(xùn)練內(nèi)部機(jī)制更易于解釋的小型稀疏模型,其神經(jīng)元之間的連接更少、更簡(jiǎn)單,從而觀察它們的計(jì)算過(guò)程是否更容易被人理解。

與普通模型不同,OpenAI 發(fā)現(xiàn)可以從該稀疏模型中提取出簡(jiǎn)單、易于理解的部件來(lái)執(zhí)行特定任務(wù),例如在代碼中正確結(jié)束字符串或跟蹤變量類型。

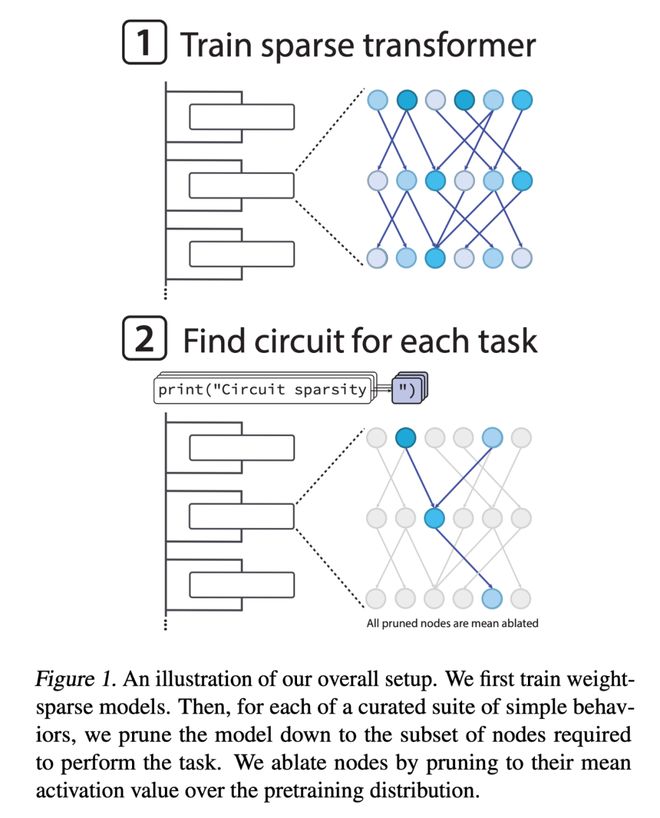

下圖為整體方法概覽,首先訓(xùn)練權(quán)重稀疏的模型,然后針對(duì)精心挑選的一系列簡(jiǎn)單行為,將模型剪枝到僅保留完成該任務(wù)所需的節(jié)點(diǎn)子集。

論文一作 Leo Gao 表示,「通過(guò)隔離稀疏模型內(nèi)部負(fù)責(zé)各種簡(jiǎn)單行為的微小電路,以前所未有的方式理解語(yǔ)言模型。」