張家輝,復(fù)旦大學(xué)大數(shù)據(jù)學(xué)院博士三年級(jí)學(xué)生,研究方向?yàn)榫呱碇悄堋⒁曈X(jué) - 語(yǔ)言 - 動(dòng)作模型預(yù)訓(xùn)練與強(qiáng)化學(xué)習(xí)后訓(xùn)練,4D-VLA (NeurIPS 25) 第一作者。黃澤,復(fù)旦大學(xué)大數(shù)據(jù)學(xué)院博士三年級(jí)學(xué)生,主要從事機(jī)器人世界模型與三維重建、生成等方向研究。兩人共同擔(dān)任本文第一作者。

張力,復(fù)旦大學(xué)大數(shù)據(jù)學(xué)院教授,上海創(chuàng)智學(xué)院全時(shí)導(dǎo)師,擔(dān)任本論文的通訊作者。主頁(yè):https://lzrobots.github.io

Vision–Language–Action(VLA)策略正逐漸成為機(jī)器人邁向通用操作智能的重要技術(shù)路徑:這類策略能夠在統(tǒng)一模型內(nèi)同時(shí)處理視覺(jué)感知、語(yǔ)言指令并生成連續(xù)控制信號(hào)。

然而,當(dāng)前大多數(shù) VLA 仍主要依賴模仿學(xué)習(xí),實(shí)質(zhì)上是按示范軌跡復(fù)刻,在分布發(fā)生偏移、任務(wù)形式變化或操作時(shí)域拉長(zhǎng)時(shí),極易出現(xiàn)誤差累積并導(dǎo)致任務(wù)失敗。強(qiáng)化學(xué)習(xí)(RL)從回報(bào)信號(hào)出發(fā)直接優(yōu)化任務(wù)成功率,按理應(yīng)當(dāng)能夠緩解這一目標(biāo)錯(cuò)配問(wèn)題,但在真實(shí)機(jī)器人上開展在線 RL 成本高昂,并行執(zhí)行受限,還伴隨大量重置與標(biāo)注開銷;以 π*0.6 為代表的多輪離線 RL 范式在每一輪中仍高度依賴真實(shí)系統(tǒng)部署和人工干預(yù),訓(xùn)練成本與迭代效率都存在明顯瓶頸(需要一直有人類介入,一旦出現(xiàn)錯(cuò)誤軌跡就人類接管操作,記錄相應(yīng)的數(shù)據(jù));另一方面,基于傳統(tǒng)物理引擎(MuJoCo、Isaac sim)的強(qiáng)化學(xué)習(xí)又難以同時(shí)兼顧逼真度、場(chǎng)景多樣性與工程可用性。

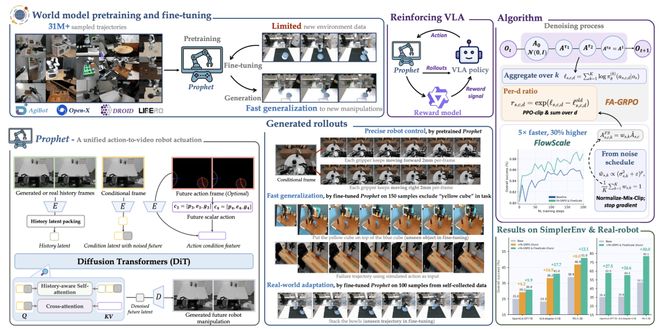

針對(duì)上述問(wèn)題,研究團(tuán)隊(duì)提出ProphRL 框架采用大規(guī)模預(yù)訓(xùn)練的世界模型 Prophet 作為「面向真實(shí)環(huán)境」的視頻級(jí)模擬器,并配合專為流式動(dòng)作頭設(shè)計(jì)的在線 RL 算法 Flow-Action-GRPO 與 FlowScale,在虛擬但物理一致的環(huán)境中直接對(duì) VLA 策略進(jìn)行強(qiáng)化學(xué)習(xí)優(yōu)化,再將優(yōu)化后的策略部署到真實(shí)機(jī)器人上。如此,策略改進(jìn)的主要探索過(guò)程可以在世界模型中完成,在兼顧物理可信度的同時(shí)顯著降低真實(shí)交互成本,為大模型 VLA 的實(shí)際落地提供了更可行的技術(shù)路徑。如圖所示:

實(shí)驗(yàn)結(jié)果顯示,ProphRL在多個(gè)公開基準(zhǔn)上為各類 VLA 模型(VLA-adapter-0.5B, Pi0.5-3B, OpenVLA-OFT-7B)帶來(lái) 5–17% 的成功率提升,在真實(shí)機(jī)器人實(shí)驗(yàn)中進(jìn)一步取得 24–30% 的大幅度成功率提升